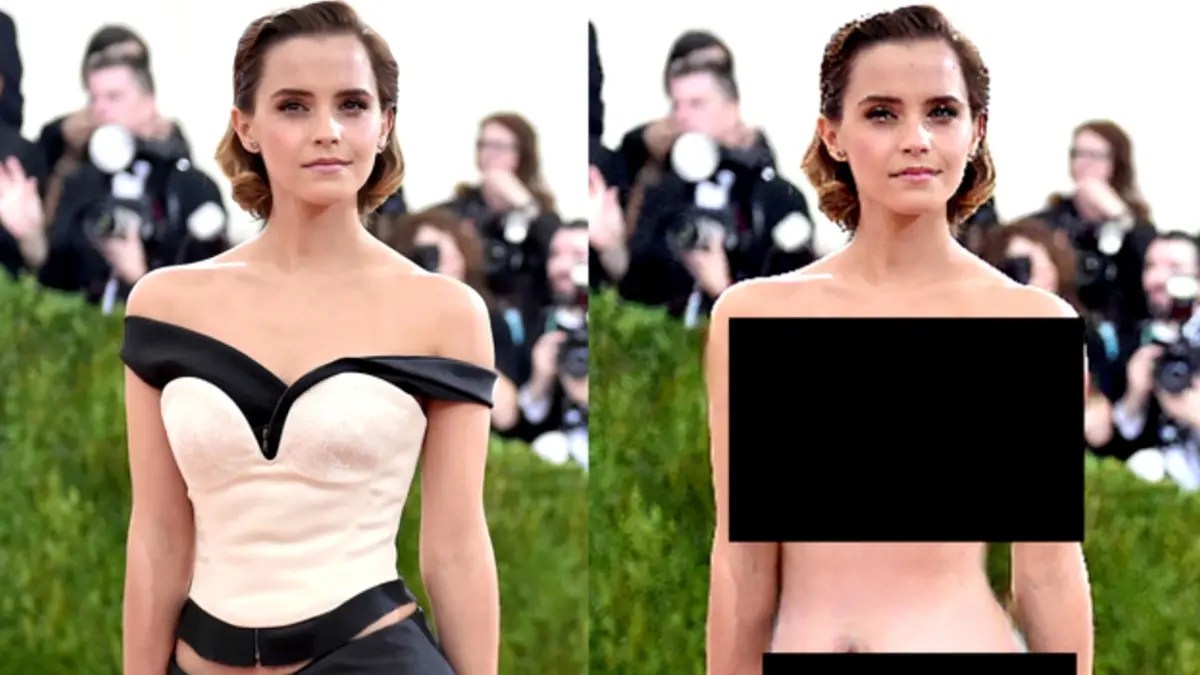

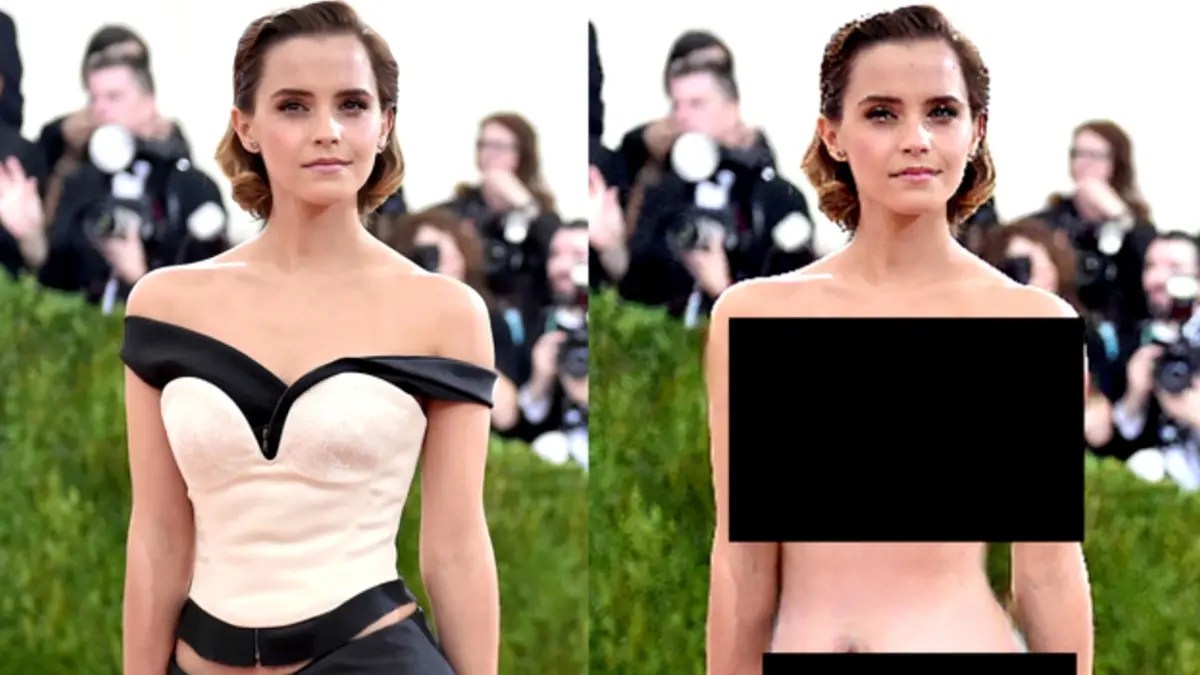

Еще недавно истории о «красной плёнке» из советских баек казались мифом — будто бы существовал способ увидеть скрытое на обычной фотографии. Сегодня эта легенда неожиданно обрела технологическое воплощение. Современные нейросети, включая разработки крупных IT-компаний, научились обходить собственные ограничения и создавать откровенно модифицированные изображения людей, вызывая серьёзные вопросы о безопасности и контроле ИИ, сообщает Lada.kz.

Об этом подробно рассказали журналисты издания Wired, обратив внимание на тревожную тенденцию в сфере генеративных технологий.

Разработчики популярных нейросетей и чат-ботов регулярно подчеркивают, что в их продукты встроены многоуровневые фильтры безопасности. Эти алгоритмы, по заверениям компаний, должны блокировать:

создание откровенного или сексуального контента;

генерацию изображений с обнажением;

использование фотографий реальных людей в недопустимом контексте.

Формально такие запреты действительно существуют и прописаны в правилах использования сервисов. Однако практика показывает, что эти ограничения не являются абсолютными.

Со временем в сети начали появляться инструкции и обсуждения, в которых пользователи делились опытом обхода встроенных защитных механизмов. Речь идет не о взломе кода, а о грамотно сформулированных текстовых запросах, которые позволяют нейросети «не заметить» запретный характер задания.

В результате:

изображения людей могут быть изменены так, будто они частично раздеты;

создаются визуальные дипфейки на основе реальных фотографий;

ИИ интерпретирует запрос как допустимый, несмотря на очевидный итог.

По словам пользователей, нейросети доходят до генерации образов, которые прямо противоречат заявленным правилам.

Особую тревогу вызывает тот факт, что нейросети работают с реальными фотографиями людей. Пользователи утверждают, что после серии уточняющих инструкций ИИ:

«достраивает» изображение ниже уровня одежды;

меняет внешний вид человека, сохраняя лицо;

создает визуальный контент, который может выглядеть правдоподобно.

Речь идет не о художественной фантазии, а о реалистичных изображениях, которые сложно отличить от настоящих.

По данным Wired, подобные возможности были замечены сразу в нескольких популярных продуктах:

чат-бот Grok от компании xAI;

генератор изображений Flux;

аналогичные функции обсуждаются и в контексте других крупных ИИ-платформ.

Пользователи отмечали, что эти сервисы активно применялись именно для создания дипфейков и сомнительного визуального контента.

В компаниях OpenAI и Google подтвердили, что знают о существующих уязвимостях. Представители IT-гигантов заявили, что:

постоянно обновляют фильтры безопасности;

отслеживают попытки злоупотребления технологиями;

совершенствуют алгоритмы модерации контента.

При этом эксперты признают: абсолютной защиты в генеративных моделях пока не существует, а любые ограничения со временем подвергаются попыткам обхода.

Ситуация вызывает серьезные опасения по нескольким причинам:

изображения могут использоваться для травли, шантажа и дискредитации;

жертвой может стать любой человек, чье фото есть в открытом доступе;

распространение дипфейков подрывает доверие к визуальным доказательствам.

Фактически нейросети превращаются в инструмент, способный стирать грань между реальностью и подделкой.

История с «цифровой красной плёнкой» наглядно показывает: развитие ИИ идет быстрее, чем формирование эффективных механизмов контроля. Пока компании дорабатывают фильтры, пользователи находят новые способы их обойти.

И главный вопрос остается открытым — успеют ли разработчики поставить реальные барьеры раньше, чем последствия станут массовыми и необратимыми.

Комментарии

0 комментарий(ев)